GPU图形产品面临新的缺货涨价风险,这次不是拜挖矿所致,而是AI人工智能,尤其是最近大火的生成式聊天机器人ChatGPT。

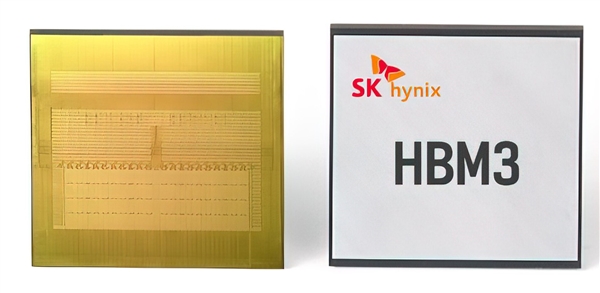

据媒体报道,包括三星、SK海力士在内的主要DRAM厂商已经提高了对显存芯片产品的报价,先进的HBM3,居然飙升了5倍之多,要知道HBM均价本就是普通DRAM的3倍,毕竟生产工艺和技术更复杂。

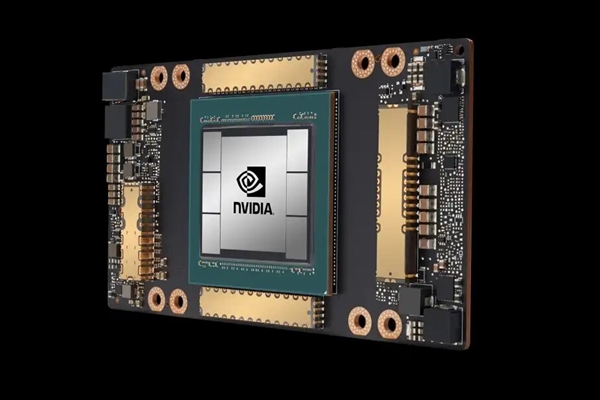

得益于超高带宽,HBM3已经得到NVIDIA计算卡H100搭载,Intel前不久推出的x86处理器Xeon Max上面也使用了HBM2e。

当然,三星也有存算一体这样的解决方案,比如HBM-PIM(Aquabolt-XL)芯片,可提供1.2T算力,SK海力士去年开发出具备计算功能的GDDR6-AiM,外界预计AI将至少在图形计算、加速器这一领域拯救低迷的DRAM需求。

但随之而来另一个隐忧是,业内对AI包括机器学习训练的跟风,或将导致GPU芯片再度短缺。据了解,为了创建和维持ChatGPT所需的人工智能分析数据的庞大数据库,开发者使用了10000个英伟达的GPU进行相关的训练。

而目前为了满足当前服务器的需求,ChatGPT的开发商OpenAI已使用了约2.5万个英伟达的GPU,随着需求的增加未来预计还会增加。每有1亿活跃用户,ChatGPT就需要13.5EPLOPS的算力,大约是6.9万台NVIDIA DGX A100 80G服务器支撑,而目前全球的算力也只能支撑1亿日均上线人数。

有专业人士推算,如果谷歌搜索全面集成Bard平台AI技术,需要512820台A100 HGX服务器,将需要超过410万个A100 GPU。

文章为作者独立观点不代表轻创业客+立场,未经允许不得转载。

浙公网安备 33038202004573号

浙公网安备 33038202004573号